Intelligenza Artificiale, è un bene o un male?

Editoriale di essecome online n. 3/2023

È di questi giorni la notizia che Geoffrey Hinton, lo scienziato considerato padre della I.A., ha lasciato Google per poter parlare liberamente dei pericoli della “sua” creazione (leggi). Il richiamo a Robert Oppenheimer, padre della bomba atomica, è immediato e questo la dice lunga sulla portata della questione.

Se la consapevolezza dei problemi connessi alla I.A. non è di oggi (ricordiamo solo “2001 Odissea nello spazio” di Stanley Kubrick che già nel 1968 aveva fatto conoscere HAL 9000, l’iconico computer immaginato da Arthur Clarke che diventa assassino di fronte ad una scelta etica), adesso le inquietudini aumentano a seguito della moltiplicazione dei suoi impieghi.

Si pensi, ad esempio, ai veicoli a guida autonoma dove vengono necessariamente affidate ad una “macchina” anche scelte estreme come dover decidere se investire un pedone o schiantarsi contro un bus carico di persone.

E in campo militare la I.A. è da tempo ampiamente utilizzata per rendere più efficaci le attività tattiche quali la scelta di bersagli e delle modalità operative (atroci eufemismi per non dire “provocare più morti”) ma è presumibile sia di supporto anche a livello strategico con tutte le implicazioni derivanti (vedi video podcast).

Tuttavia, a dispetto delle preoccupazioni, la lista di situazioni in cui decisioni estreme verranno prese da macchine è inevitabilmente destinata ad allungarsi a dismisura, per cui è necessario affrontare l’argomento in modo razionale e non emotivo.

Per cominciare, proviamo a rispondere a due domandine facili facili:

1. Chi insegna alle macchine i criteri di scelta ovvero da dove deriva il loro imprinting etico?

2. Sapere che è un “umano” a decidere nelle situazioni estreme è davvero sempre così rassicurante?

Le risposte aprono la stura a considerazioni di ordine morale, politico e perfino religioso che a prima vista esulerebbero dai nostri ambiti ma, in realtà, il problema di base è ancora una volta la sicurezza, da qualsiasi parte lo si giri.

Se, giustamente, ragioniamo in termini di sicurezza quando ci chiediamo quali siano i criteri di scelta insegnati alle macchine che in qualche modo interagiscono con le vite di umani e chi siano i loro “insegnanti”, non lo sarebbe forse anche chiedersi quali siano le condizioni psico-fisiche dei governanti con la valigetta dell’arsenale atomico, degli autisti di scuolabus pieni di bambini, degli infermieri in camera operatoria, delle guardie giurate che tornano a casa con la pistola di servizio, solo per fare qualche esempio di umani ai quali vengono affidate le vite di altri umani?

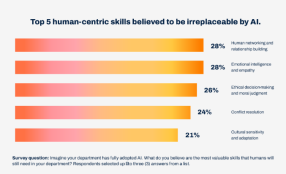

Su un piano diverso, ricordiamo che fino a non molto tempo fa serpeggiava l’allarme per la sostituzione di posti di lavoro per umani con macchine e si pensava a padroni senza cuore che mettevano i robot al posto degli operai solo per aumentate il profitto.

Oggi, la mancanza strutturale di manodopera di ogni livello a causa del crollo demografico e della concorrenza di paesi che offrono condizioni di lavoro migliori, anche nell’Italia umanista imprese di ogni genere sono alla disperata ricerca di macchine con più “intelligenza” possibile a bordo semplicemente per continuare l’attività e poter pagare gli stipendi ai lavoratori rimasti.

Ma allora, la I.A. è un bene o un male?

(In caso di riproduzione anche parziale, citare la fonte)