Intelligenza artificiale, sicurezza e responsabilità civile. Interviene la Commissione Europea

di Laura Lenchi, avvocato del Foro di Pavia - docente di securindex formazione

Nel corso degli ultimi anni l’Unione ha dimostrato un notevole interesse verso l’IA, riconoscendone il potenziale e la necessità di investimenti significativi.

L’indiscussa utilità delle tecnologie, in continua e repentina evoluzione, porta con sé una serie di problematiche e criticità, soprattutto in materia di sicurezza e responsabilità.

Nella relazione sulle implicazioni dell’intelligenza artificiale, dell’Internet delle cose e della robotica in materia di sicurezza e di responsabilità del 19 febbraio 2020 che accompagnava il Libro Bianco sull’intelligenza artificiale, la Commissione sottolineava che, per incentivare l’utilizzo dell’IA e raggiungere l’obiettivo di “fare dell’Europa un leader mondiale nel campo dell’Intelligenza artificiale”, era necessario garantire che tutti i prodotti e servizi, compresi quelli che integrano le tecnologie digitali emergenti, funzionassero in modo sicuro, affidabile e costante e che vi fossero rimedi efficaci in caso di danni.

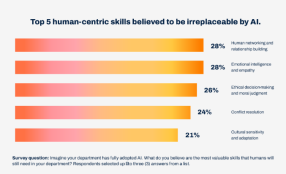

Da un’indagine sulla diffusione delle tecnologie basate sull’intelligenza artificiale tra le imprese europee realizzata nel 2020, era infatti emerso che la responsabilità costituiva l’ostacolo esterno più rilevante per le imprese che intendevano adottare prodotti e sistemi basati sull’IA. Secondo la Commissione, le norme in materia di responsabilità devono sempre trovare un equilibrio, tutelando i cittadini dai danni e consentendo allo stesso tempo alle imprese di innovare. In realtà, la frammentazione delle legislazioni e della giurisprudenza all’interno dell’Unione impedisce di raggiungere tale risultato. In tema di responsabilità extracontrattuale, le norme nazionali solitamente prevedono che spetti alla parte danneggiata l’onere di provare che il danno subito sia conseguenza di un’azione od omissione colposa da parte di un terzo.

Le caratteristiche specifiche dell’IA e, in particolare, la complessità ed i costi necessari per ricostruire il processo decisionale del sistema (cd. “effetto scatola nera”) spesso non consentono di identificare il soggetto responsabile. La difficoltà nel fornire una simile prova, data dalla complessità, dall’autonomia e dall’opacità del settore dell’IA, andrebbe a discapito dei consumatori che potrebbero essere dissuasi dall’affrontare lunghi ed incerti giudizi.

Inoltre, questa incertezza potrebbe indurre i diversi Stati a interventi legislativi diversificati, finalizzati a riconoscere ai consumatori per danni causati da un sistema di IA una tutela equivalente a quella riservata ai consumatori che riportano danni da prodotti difettosi, secondo la Direttiva 85/374/CEE...

Clicca qui sotto per leggere l'articolo completo: